Les pièges à éviter

Même avec les meilleures intentions, il est facile de saboter ses vacances. Voici quelques pièges classiques.

Le mail furtif : "juste pour vérifier". Ce clic en apparence anodin suffit à relancer la boucle mentale du travail.

L’agenda surchargé : transformer ses vacances en planning militaire de loisirs.

Le besoin de rentabilité : vouloir "profiter à fond", faire des check-lists de musées, de restos, de spots.

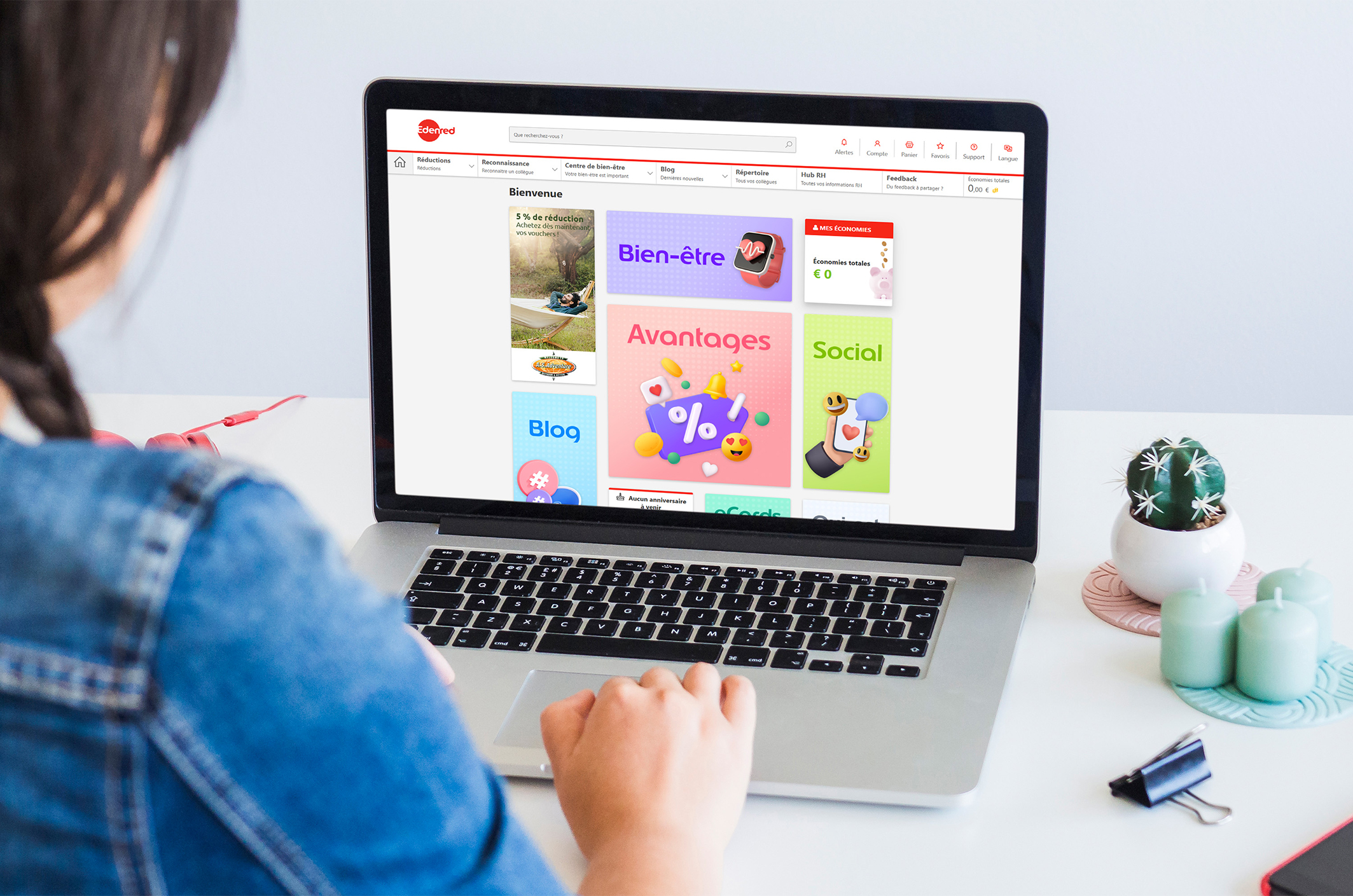

La pression sociale : poster chaque journée sur les réseaux, se comparer, valider ses choix.

L’absence de transitions : passer du bureau à la plage sans sas, et revenir, pareillement brutalement.